Indice:

1.- Vídeo Digital, ¿en qué consiste?

2.- Práctica.

3.-Vídeo Digital, lo que también debes saber.

4.- Glosario.

5.- Conclusión.

————– + ————-

1.- Vídeo digital, ¿en qué consiste?

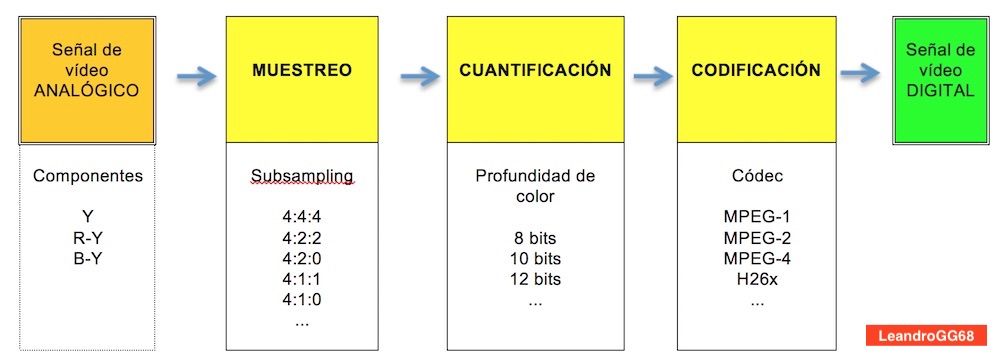

El vídeo digital consiste en aplicar los tres procesos de digitalización a una señal de vídeo analógico. Estos procesos son: el muestreo, la cuantificación y la codificación.

Cada uno de estos procesos generará una serie de variantes que darán lugar a las decenas de formatos de vídeo digital que coexisten en la actualidad.

Muestreo.

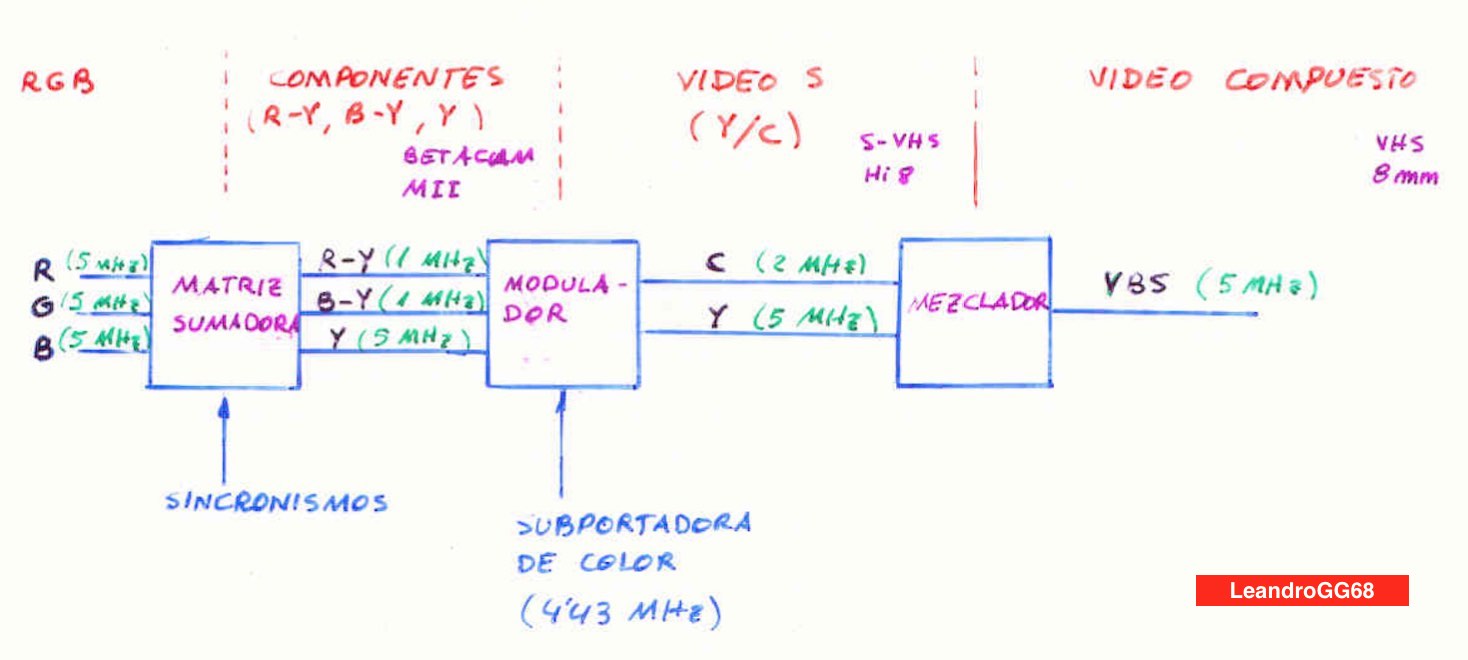

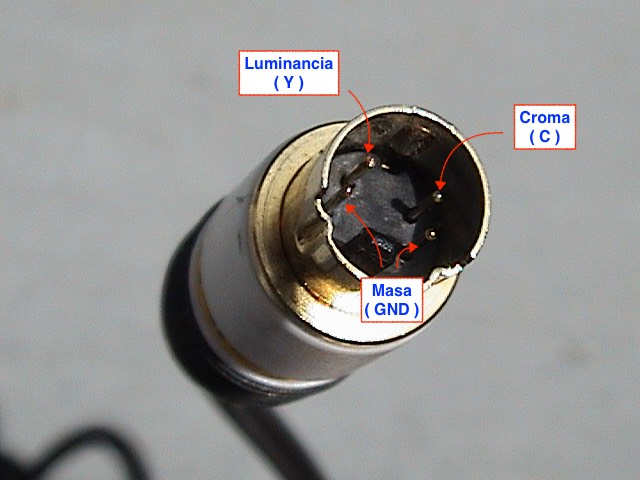

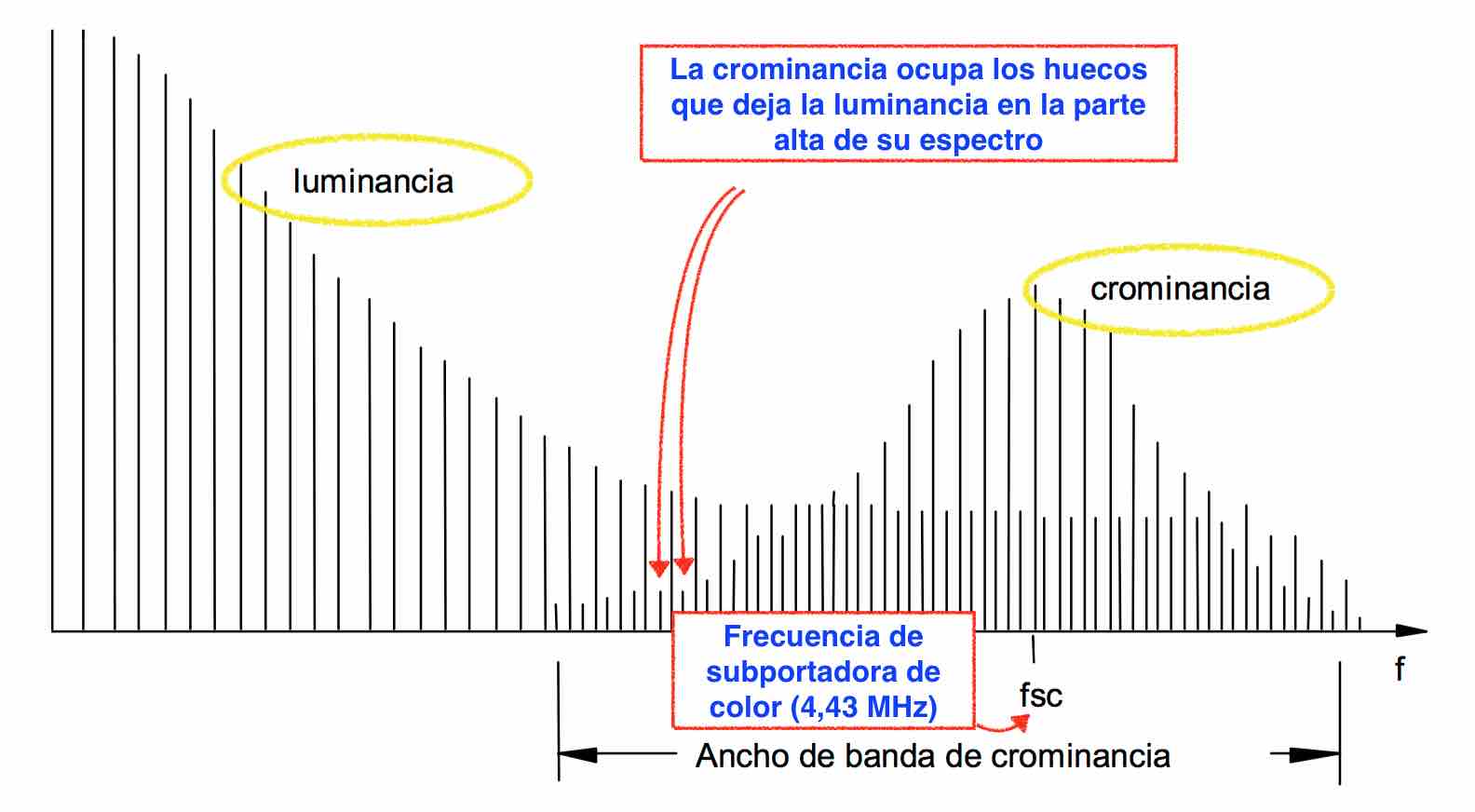

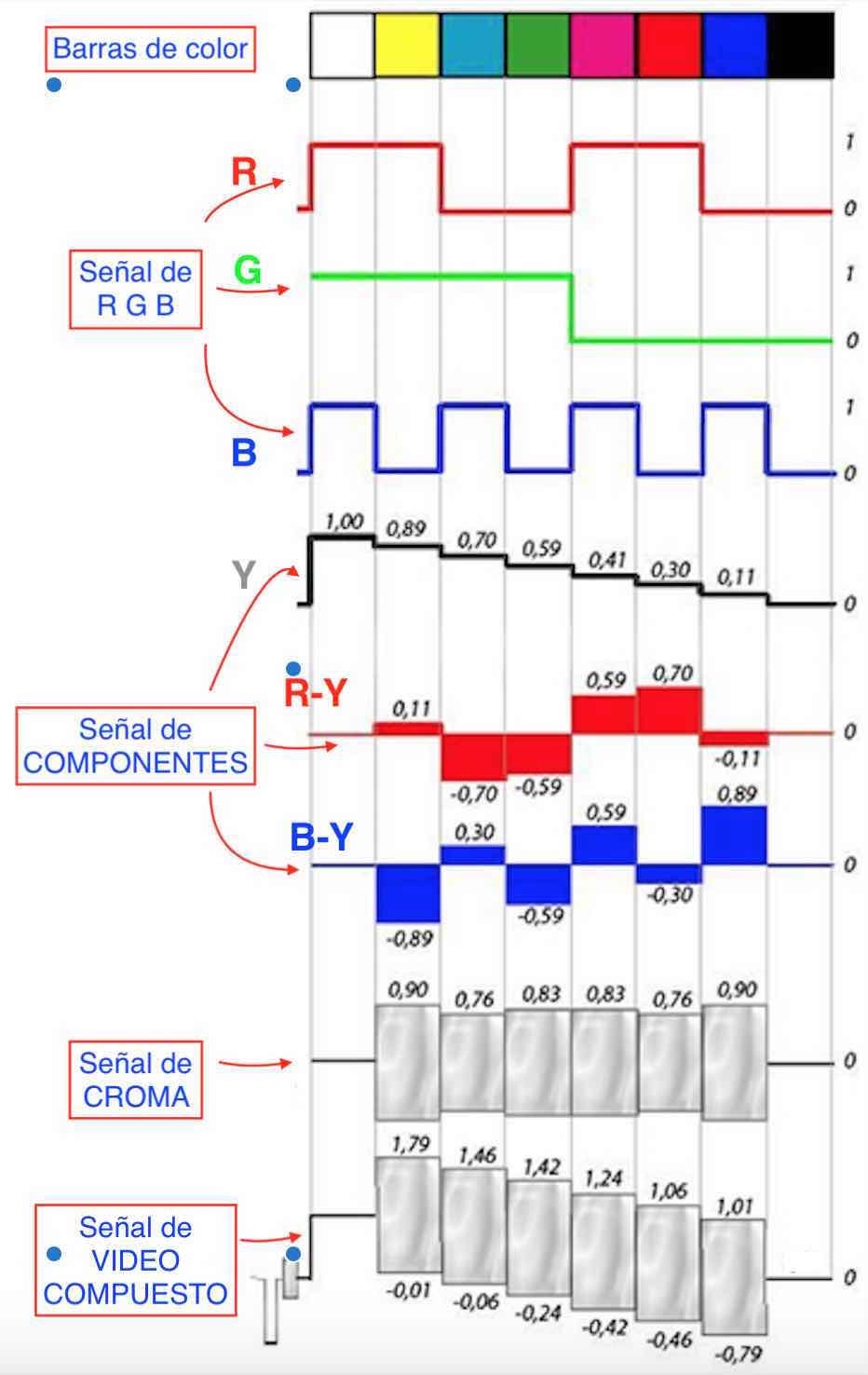

Consiste en tomar muestras de una señal de vídeo analógico, lo usual es que se haga de la señal en componentes (Y, R-Y, B-Y), aunque cuando se busca la máxima calidad en la señal digital el muestreo se hace de la señal RGB.

Cuando el muestreo se hace a partir de la señal en componentes se le llama subsampling1 y consiste en tomar muestras de cada componente de la señal, es decir, de la luminancia (Y), de la componente de rojo (R-Y) y de la componente de azul (B-Y).

Cuantificación.

Las muestras obtenidas del subsampling, deben ser cuantificadas, es decir, se les debe asignar una palabra binaria, de esta forma aparece el concepto de profundidad de color1 que hace referencia al nº de bits que se utilizarán para identificar cada muestra obtenida del subsampling.

Codificación.

Después de la cuantificación, normalmente de 8,10 ó 12 bits, el flujo binario obtenido es muy alto, varios cientos Mb/s (Mega bits por segundo), se necesitan unos discos duros rápidos para poder grabarlo y ocuparía mucho espacio. Esto no es funcional por lo que se requiere el último paso: la Codificación.

Con la codificación reducimos el flujo binario o bitrate1 , con lo que cada minuto de vídeo nos ocupará menos MB (Mega Bytes) en el disco duro y no necesitaremos discos duros tan rápidos.

La codificación genera inconvenientes:

1º Pérdida de calidad irreversible en el vídeo.

2º Pérdida de calidad en las transcodificaciones (exportar el vídeo para llevarlo a otros programas).

3º Menos fluidez al trabajar en la edición.

La solución pasa por usar un codec1 adecuado. Si vamos a trabajar con varios programas, interesa un codec con poca compresión, un muestreo alto ( 444 ó 422) y una profundidad de color alta (10 ó 12 bits).

Los programas de edición, cuando realizamos la importación de material, nos preguntarán con qué codec deseamos trabajar, por ejemplo Final Cut por defecto trabaja con ProRess 422, por tanto convertirá el formato del vídeo importado a ProRess 422 para trabajar de forma más fluida.

2.- Práctica.

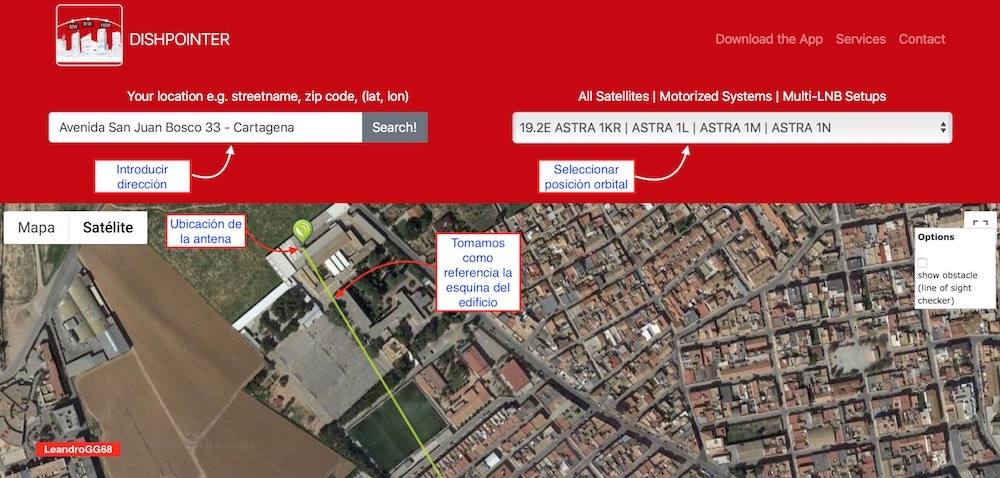

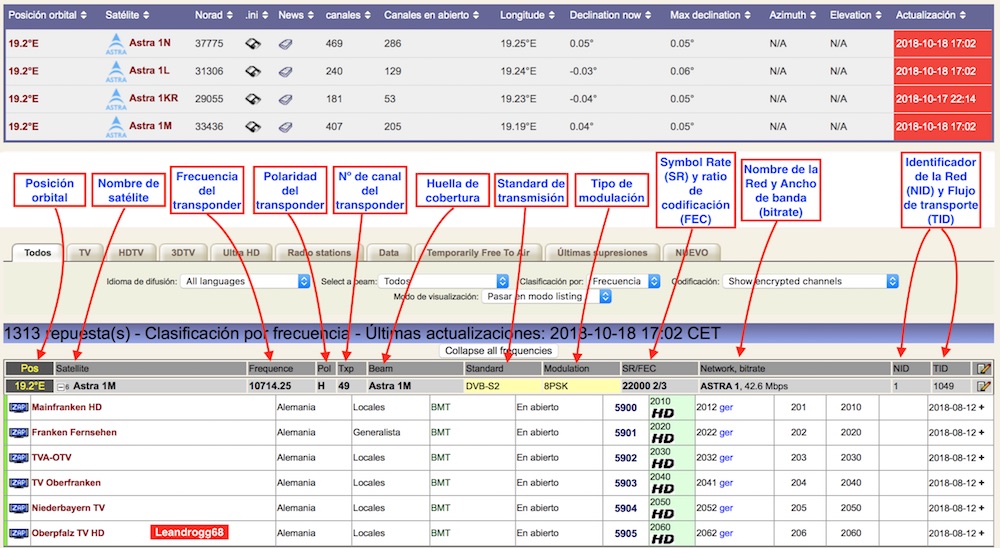

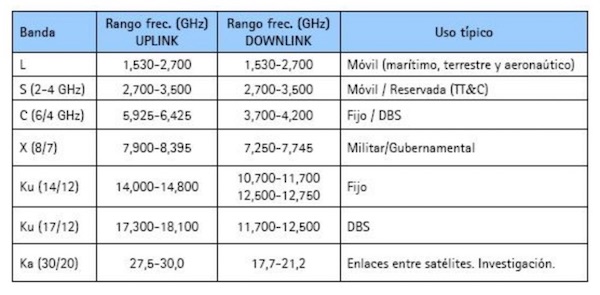

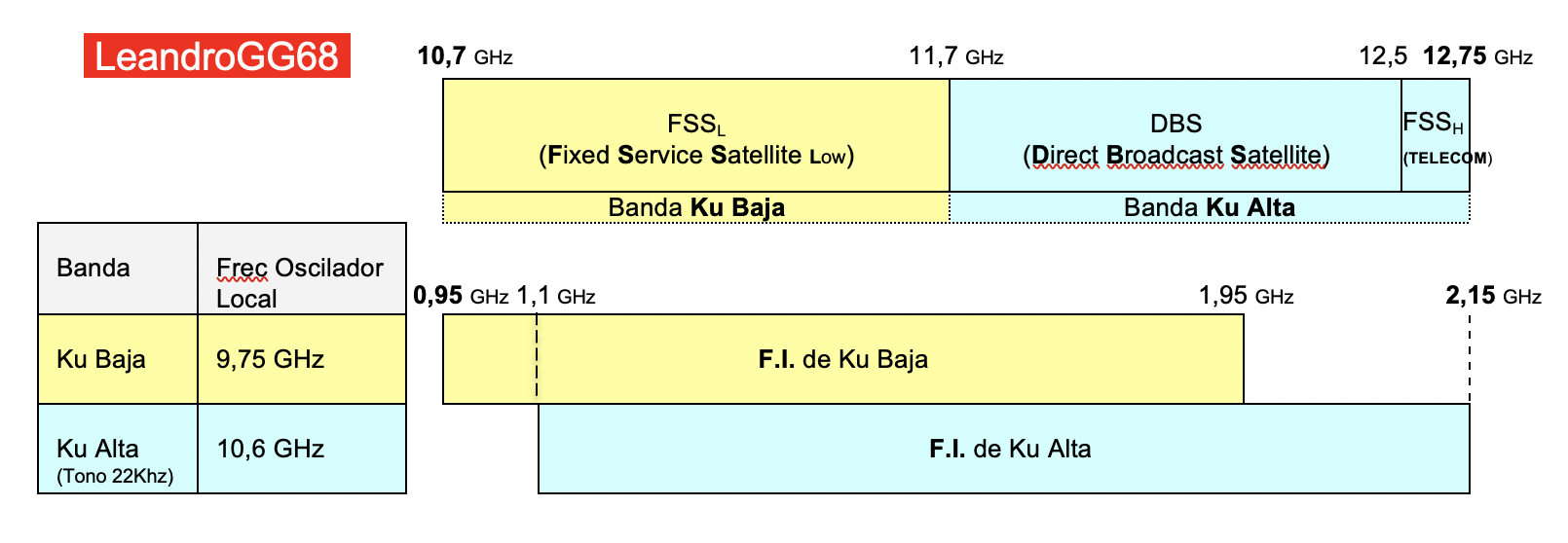

En el siguiente enlace se puede descargar la Ficha de Prácticas que utilizan mis alumnos de Formación Profesional de la rama de Telecomunicaciones. En ella, previo a la práctica, realizan los esquemas de montaje y la resolución de cuestiones preparatorias. Tras su revisión, proceden al montaje de la práctica y toma de medidas y/o datos.

Enlace a Práctica “ Grabación y Formatos de vídeo digital “

Vídeo Informe más representativo Curso 18 19

3.- Vídeo Digital, lo que también debes saber.

Frame Rate

Es la cantidad de imágenes (frames) por segundo capturadas por una cámara o mostradas por un dispositivo de visualización. Se utilizan las siglas «fps» (frames por segundo).

Veamos una clasificación de los formatos de vídeo en función de su frame rate:

Cine (4K): 24 fotogramas/seg. Hay algunas películas que están utilizando 48 por ejemplo «El hobbit: un viaje inesperado», con ello se consiguen movimientos más reales.

PAL (720×576) : 25fps y 50i (entrelazado) para emisión en TV.

NTSC (720×480) : 29,97 ó 30fps y 59,94i ó 60i para emisión en TV.

HDTV (1280×720 ó 1920×1080) : desde 23,976 a 60 fps. En emisión de TV: 720p (deportes) y 1080i (resto de programas).

UHDTV (4k y 8k) : desde 23,976 a 120 fps (ya no utiliza el escaneo entrelazado).

La «i» indica que se usa un sistema de escaneo entrelazado1 (interlaced), en el cual la imagen completa (cuadro o frame) está formada por dos semimágenes denominadas campos.

Cuando el sistema NTSC introdujo el color en 1953, la tasa de 60 campos por segundo fue reducida en un factor de 1000/1001 para evitar la interferencia entre la señal de color y la de sonido. Apareció entonces el frame rate de 29.97 fps y 59,94i (30 cuadros y 60 campos) , esto ha perdurado hasta la actualidad, pero ya no tiene sentido su uso, por lo que actualmente es mejor usar 30 fps ó 60i, siempre que el equipo a configurar lo permita.

En edición de vídeo conviene trabajar con material en progresivo, además con un frame rate alto se evita el desenfoque de la imagen con el movimiento (motion blur) y se mejora la visualización en cámara lenta.

Resolución

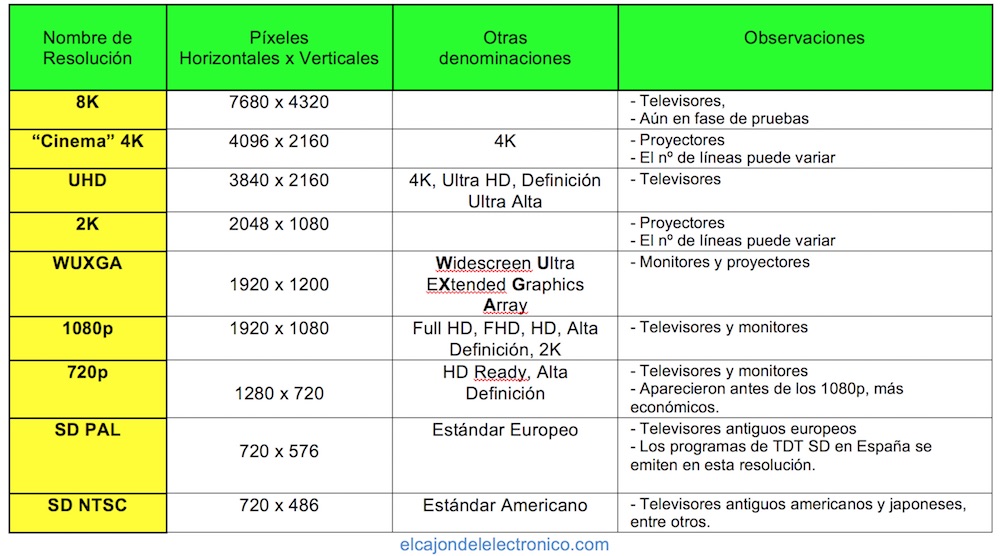

Es el nº de píxeles que contiene la imagen. Viene determinada por dos números, el primero indica la cantidad de pixeles en horizontal (píxeles por línea) y el segundo en vertical (nº de líneas).

Las resoluciones 2K y 4K se definieron por la DCI (Digital Cinema Initiatives) que es un consorcio que apareció en 2002, cuyos miembros fundadores fueron los siete mayores estudios de cine estadounidenses (Walt Disney Pictures, Fox Broadcasting Company, MGM, Paramount, Sony Pictures Entertainment, Universal Studios y Warner Bros). Este consorcio emitió en 2005 las recomendaciones técnicas para la Producción de Cine Digital (DCP) ya que hasta esa fecha no había ningún tipo de norma.

Códecs y contenedores

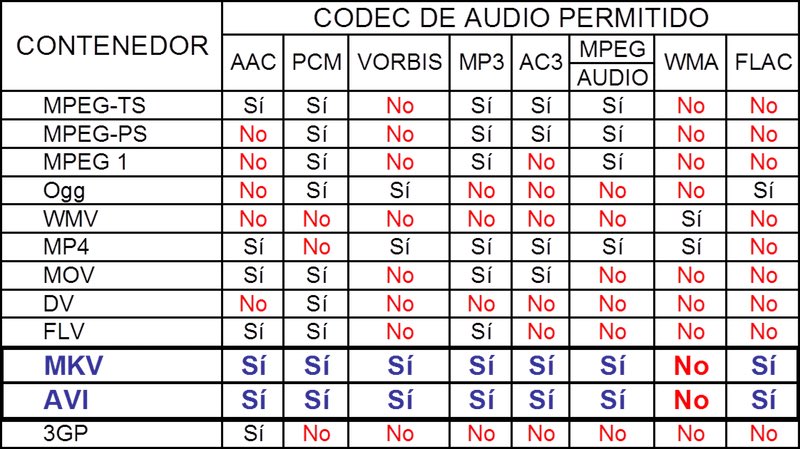

Los códecs son algoritmos realizados con software para comprimir y descomprimir una trama digital con vídeo y audio en tiempo real.

Al archivo generado se le denomina Contenedor y es el que determina la organización de la información de audio, vídeo y metadatos. Cada contenedor soportará unos códec de audio y vídeo determinados. En las tablas siguientes se muestran algunos contenedores y códecs de uso común.

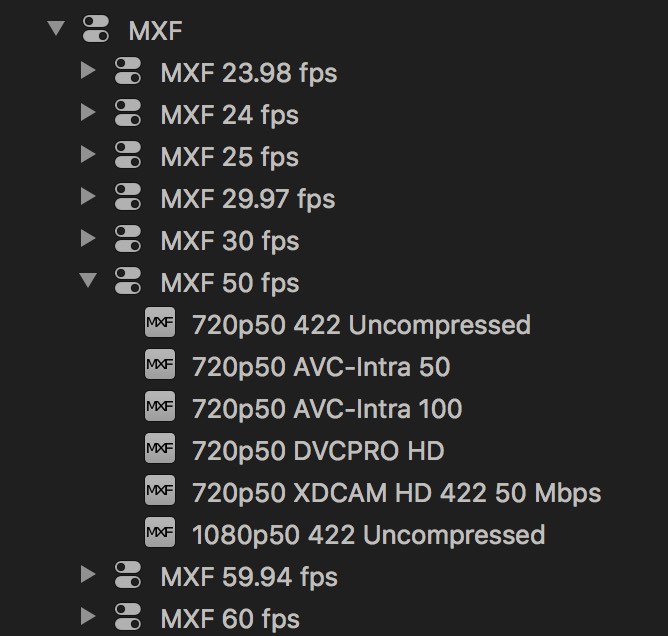

Un contenedor muy usado para el intercambio de material entre profesionales es el MXF. La figura siguiente muestra las opciones MXF que ofrece el programa Compressor de Apple, vemos como puede contener diferentes códecs.

Hay varias versiones de MXF (Patrones Operacionales) con especificaciones particulares que definen el tipo de imagen/sonido que contiene y la estructura de los metadatos. Las versiones más comunes son la OP-1a y la OP-Atom, quedando identificadas en los programas de codificación como MXF OP-1a y MXF OP-Atom. Un archivo .mxf puede ser reproducido sin problemas con el reproductor VLC.

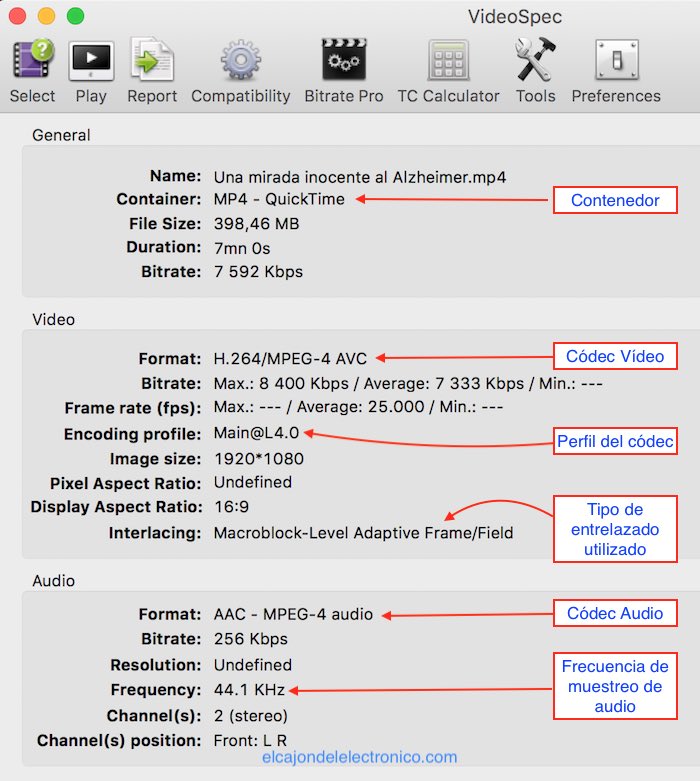

Con aplicaciones gratuitas como videoSpec (OSX), Format Factory (Windows) o mediainfo, podemos inspeccionar las características de cualquier vídeo.

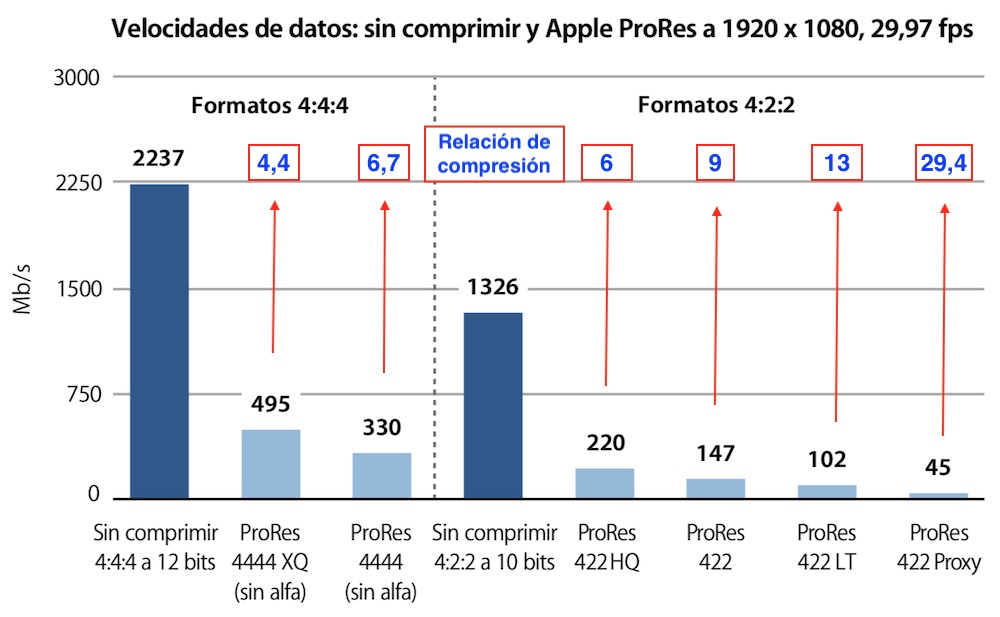

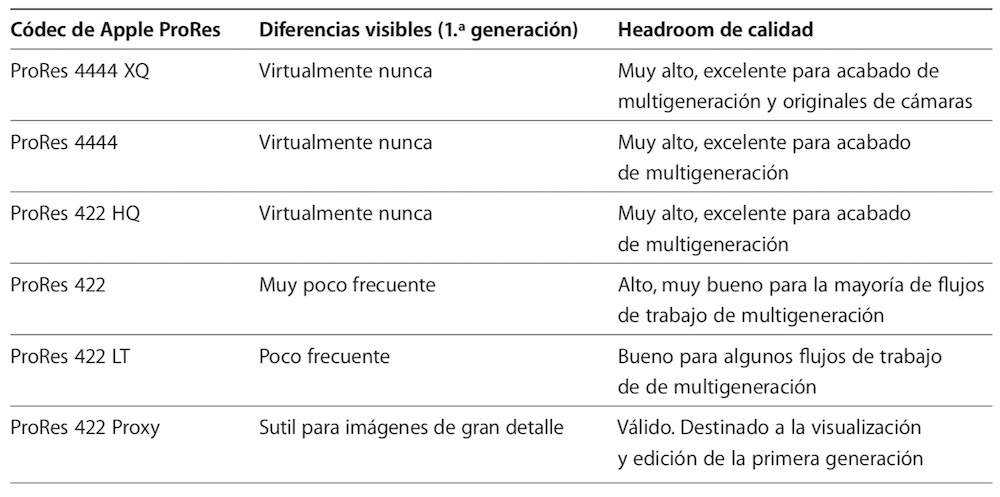

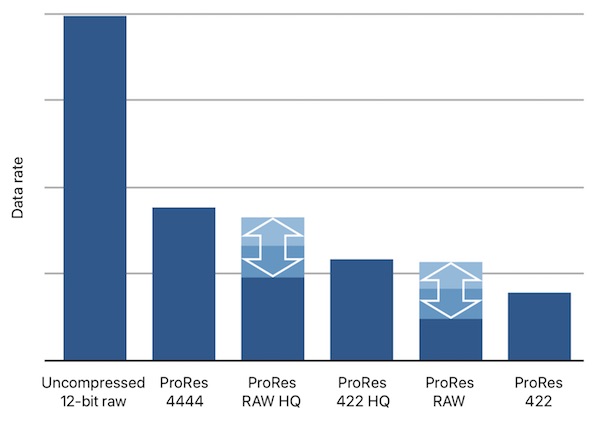

Códec Apple ProRes

Son una familia de códecs de mucha calidad muy usados sobre todo en entornos MAC, aunque también en windows pero con algunas restricciones. Sus características vienen definidas en un documento llamado libro blanco (white paper) que se actualiza periódicamente.

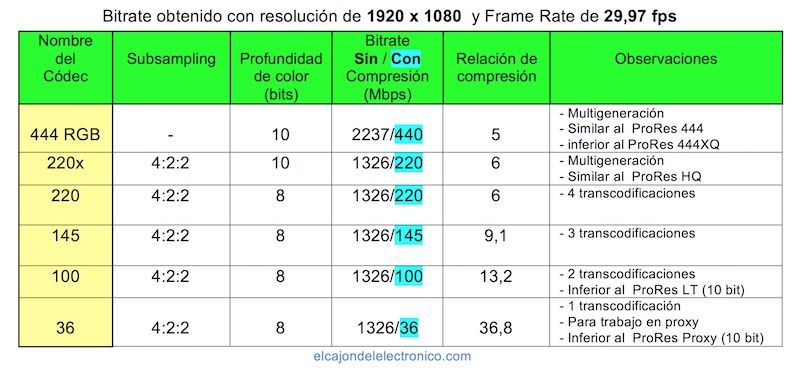

Códecs AVID DNxHD.

Esta familia de códecs es más numerosa que la ProRes, en la siguiente tabla se muestran los más usuales. Obsérvese que por debajo de 220x, la profundidad de color es de 8 bit mientras que en ProRes se mantiene a 10 bits.

Códecs H264.

H.264 ó MPEG-4 parte 10 es una norma que define un códec de vídeo de alta compresión, desarrollada conjuntamente por el ITU-T Video Coding Experts Group (VCEG) y el ISO/IEC Moving Picture Experts Group (MPEG). Este códec mejora a los de los estándares anteriores: MPEG-2, H.263 o MPEG-4 parte 2.

La ITU-T quiso ponerle el nombre: ITU-T H.264 y el ISO/IEC prefería: MPEG-4 Parte 10 Códec de Video Avanzado (AVC), al final, ni para uno ni para el otro, le pusieron: H.264/MPEG-4 AVC.

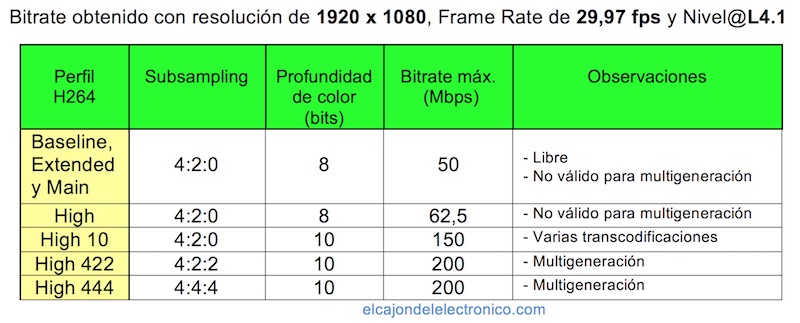

La norma H.264, distingue varios Perfiles (o extensiones) y dentro de cada perfil varios Niveles (Layers). En la tabla siguiente se ha tomado como ejemplo el Nivel @L4.1 para varios perfiles.

Veamos un par de ejemplos:

Main@L4.0 : perfil Main y nivel 4.0 (este es libre, los fabricantes no pagan ningún canon por implementarlo en sus cámaras).

High@L5.1 : perfil High y nivel 5.1.

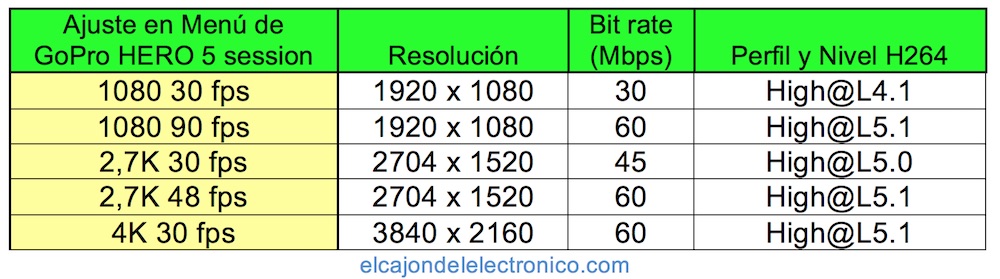

En esta tabla se analizan los perfiles H264 de varios ajustes de la cámara de acción GoPro HERO5 Session.

En este enlace se pueden ver las especificaciones de los perfiles así como las características de los diferentes niveles disponibles para la norma H264.

Códecs H265.

Recibe los siguientes nombres: H.265 , MPEG-H Parte2 ó HEVC (High Efficiency vídeo Coding).

Es una norma sucesora al H.264/MPEG-4 AVC y desarrollado por el mismo grupo de trabajo.

Se organiza de forma similar al H264, en perfiles (extensiones) y niveles. Para adaptarse a cualquier uso se han definido 9 perfiles y 13 niveles, en este enlace pueden verse.

Ventajas respecto al H264:

- Mantiene la calidad con bitrates 2 ó 2,5 veces inferiores, por lo que es muy interesante para la grabación en 4K, prácticamente todos los teléfonos móviles que graban en 4K lo implementan.

- Puede trabajar con vídeo de hasta 8K y 300 fps mientras que el H264 sólo hasta 4K 60 fps.

Formato RAW.

Raw significa grabación en bruto, este formato contiene toda la información entregada por el sensor de la cámara, por ello el formato RAW nos proporciona la mejor imagen que pueda dar la cámara.

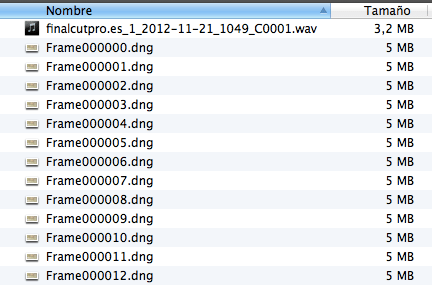

Un ejemplo de flujo de trabajo para RAW tipo CinemaDNG puede ser el siguiente:

1.- La cámara genera dos tipos de archivo: .dng (foto) para cada frame de video y .wav para el audio.

2.- Con un programa como DaVici Resolve se importan los archivos DNG y se retoca la colorimetría, encuadre, balance de blancos y exposición.

3.- Se exporta la secuencia a un formato como el ProRes 422 HQ.

4.- Se importa la secuencia con un programa de edición, por ejemplo Final Cut Pro X y se procede a su edición.

Ventajas:

- Se conserva toda la información, viéndose con más calidad.

- Mayor profundidad de color, normalmente 12 o 16 bits con lo que se mejora el tratamiento del color y los degradados.

- Permite modificar el balance de blancos en postproducción.

- Permite mover los valores de exposición uno o dos puntos, por encima o por abajo sin apenas generar ruido en la imagen. Esto hace que podamos modificar el rango dinámico en postproducción.

Inconvenientes:

- Incremento de bitrate.

- Un flujo de trabajo (workflow) más complicado. Hay que exportar el archivo RAW a una secuencia de DNGs, para después hacer la corrección de color pertinente y volver a importarlos para crear la secuencia.

- Es necesario un ordenador más potente con discos rápidos (SSD) y mucho espacio de almacenamiento. Como ejemplo, en una cámara Blackmagic Cinema en raw con resolución 2400×1350 a 24 fps graba unos 7GB por minuto.

Formatos habituales usados para grabación en RAW:

- CinemaDNG (2008): desarrollado por Adobe.

- ProRes RAW (2018): desarrollado por Apple.

- Blackmagic RAW (2018): desarrollado por Blackmagic.

Conexiones en vídeo digital.

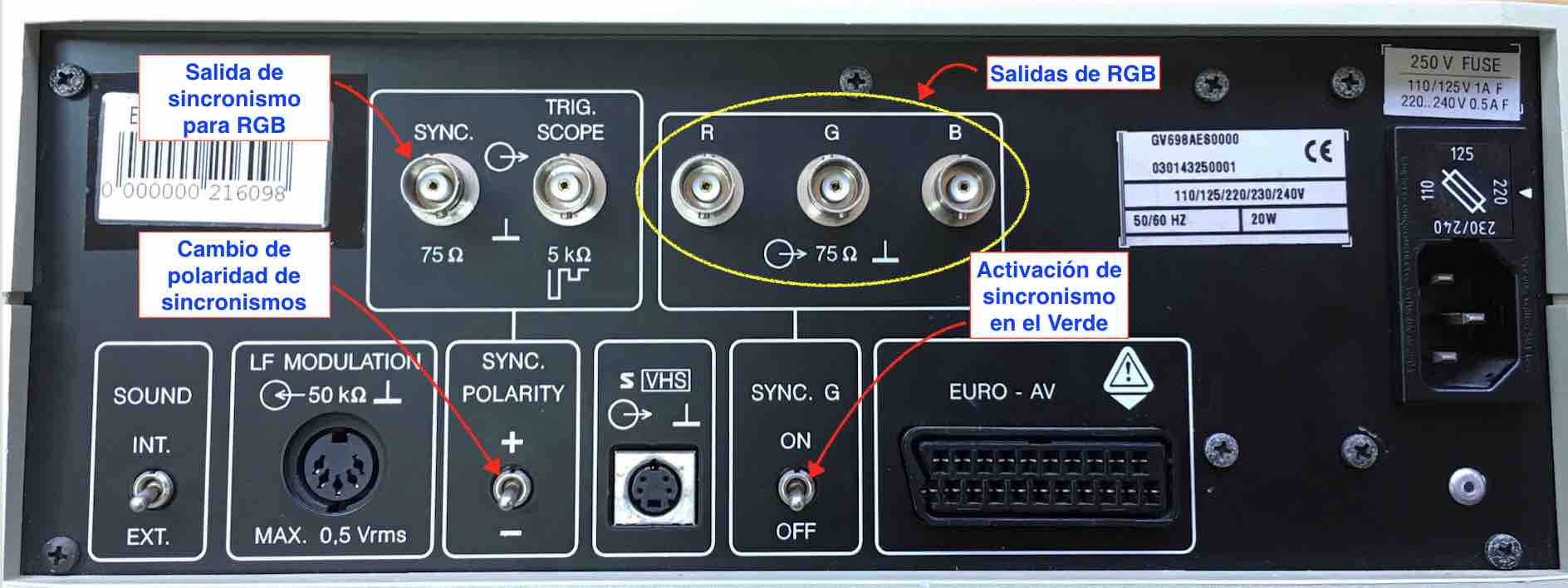

SDI.

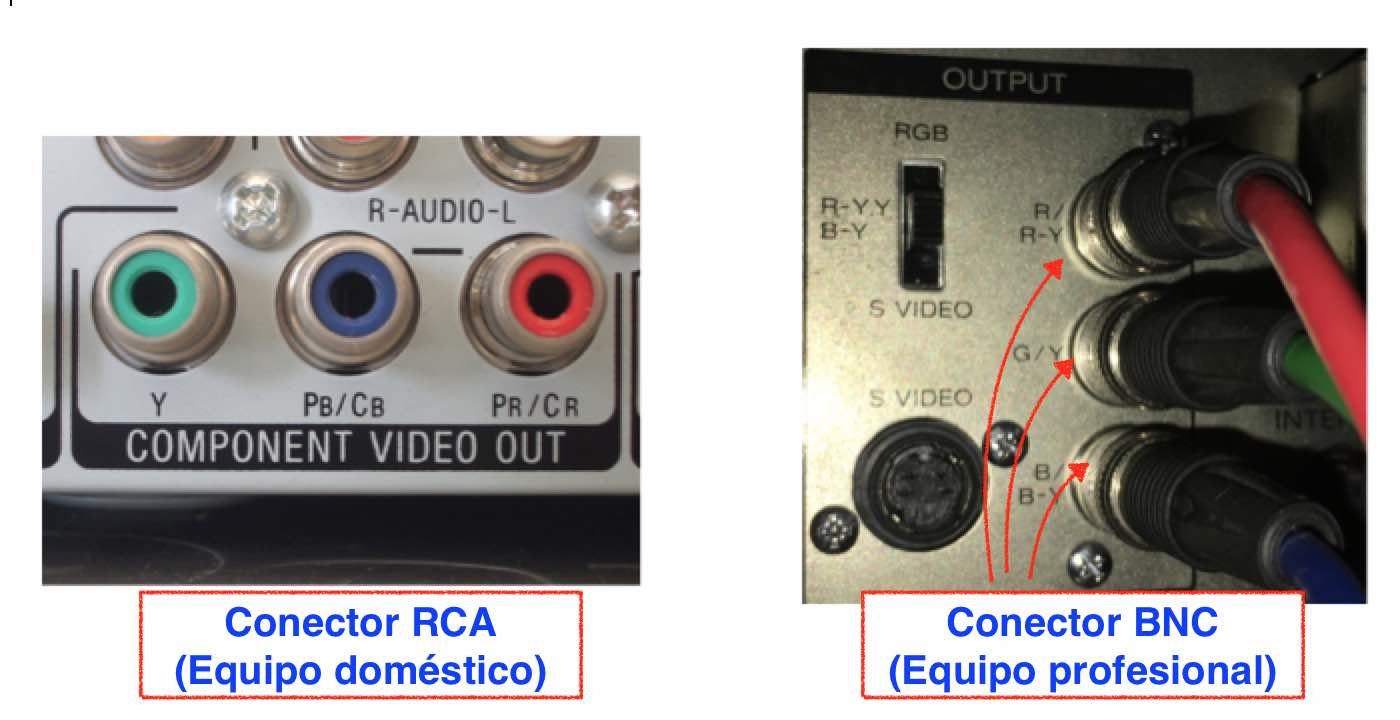

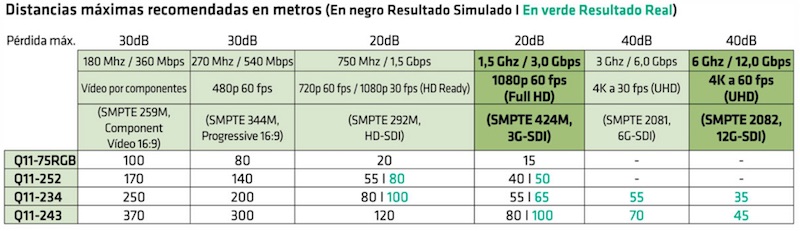

SDI responde a las siglas Serial Digital Interface, transmite señal de vídeo, audio y datos por un solo cable, es el interfaz predominante para la comunicación de equipos de vídeo profesionales. Se utiliza un cable coaxial de 75 Ω de impedancia y conectores BNC.

La longitud del cable máxima dependerá de la calidad del cable y del tipo de señal SDI transportada.

Los diferentes tipos de señales SDI han sido creadas paulatinamente según han ido apareciendo nuevas resoluciones de vídeo en el mercado. Cada una de ellas está definida por un estándar distinto que marca los parámetros que la caracterizan.

Estos estándares los crea la sociedad americana SMPTE (Society of Motion Picture and Television Engineers), una asociación de ingenieros especializados en vídeo que actúan como propulsores marcando las características que deben cumplir estas señales.

SDI estándar ( SMPTE 259m y SMPTE 344m ): creado para regular las señales de definición estándar con resoluciones de 480 y 576 entrelazadas y progresivas.

HD-SDI (SMPTE 292m): Para señales de 720p y 1080i a 60 fps con un bitrate de 1,50Gbps.

3G-SDI (SMPTE 424m): Para señales de 1080p a 60 fps con un bitrate de 3Gbps.

6G-SDI (SMPTE 2081): Para señales de 4K a 30 fps con un bitrate de 6Gbps.

12G-SDI (SMPTE 2082): Para señales de 4K a 60 fps con un bitrate de 12Gbps.

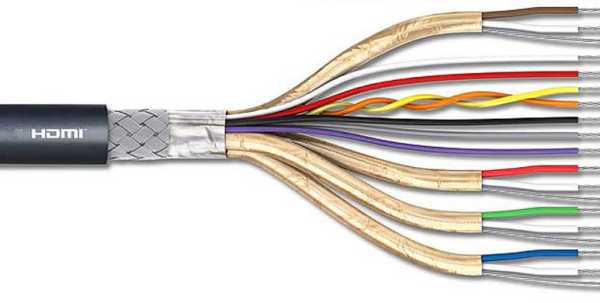

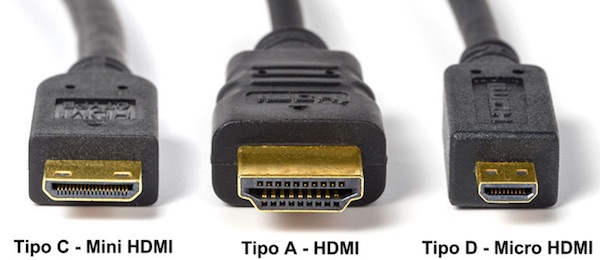

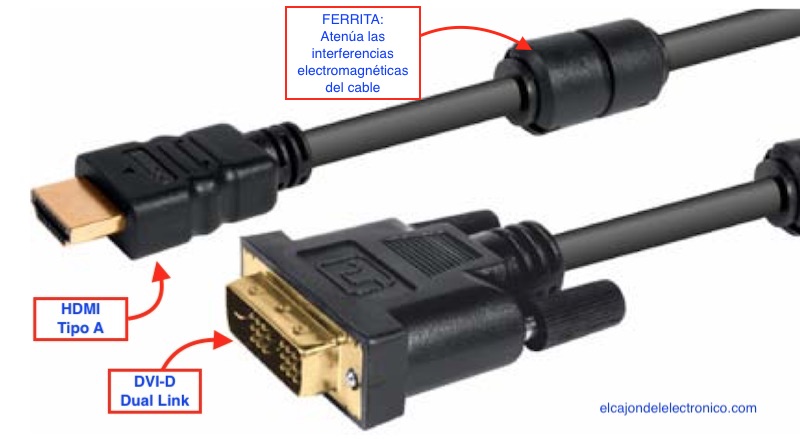

HDMI.

HDMI responde a las siglas de High Definition Multimedia Interface. Apareció en 2003 y permite conectar vídeo y audio digital sin compresión entre dos dispositivos a través de un único cable.

Ha habido varias versiones de HDMI, siendo compatibles hacia atrás, veamos las últimas:

HDMI 1.4 (2009).

- Resolución: 1080/60 fps y 4K (4096 x 2160 /24 fps ó 3840 x 2160 /30 fps).

- Máximo ratio de transferencia: 10,3 Gbps.

- 3D: 1080p a 60 fps.

- Audio: 8 canales / 192 kHz.

HDMI 2.0 (2013)

- Resolución: 4K (4096 x 2160 /60 fps).

- Máximo ratio de transferencia: 18 Gbps.

- 3D: 4K a 25 imágenes/segundo.

- Soporte para trabajar con la tecnología HDR (High Dinamic Range).

- Audio: 32 canales / 1536 kHz.

HDMI 2.1 (2017)

- Resolución: 8K a 60 fps y 4K a 120 fps.

- Máximo ratio de transferencia: 48 Gbps.

- Soporte para trabajar con la tecnología HDR.

- Audio: 32 canales / 1536 kHz.

Además del audio y el vídeo, el cable HDMI permite realizar otras conexiones:

CEC (Consumer Electronics Control): Se introdujo a partir del HDMI 1.0 y sirve para enviar comandos de control entre aparatos de forma que con un mando a distancia se controlan los equipos conectados por HDMI. No todos los fabricantes lo implementan en sus equipos.

ARC (Audio Return Channel): desde el HDMI 1.4 y sirve para que un televisor pueda transmitir audio hacia un amplificador de Home Cinema por ejemplo. Nos ahorra el tener que conectar un cable de audio entre ambos equipos.

HEC (HDMI Ethernet Channel): desde el HDMI 1.4 y sirve para realizar una comunicación Ethernet a 100 Mbit/s entre los equipos conectados.

En cuanto a la distancia máxima de un cable HDMI, a partir de unos 12 metros, es necesario usar cables de calidad superior a la estándar, es posible encontrar cables de hasta de 20 m, si se desea una distancia mayor, hay que insertar un amplificador de HDMI.

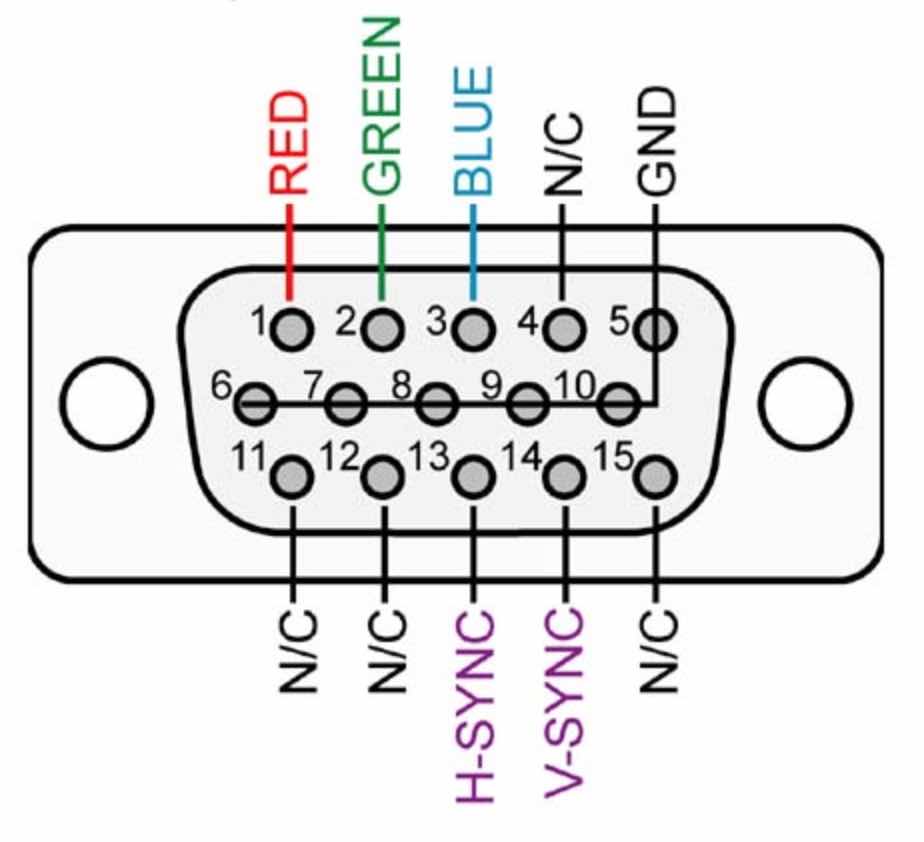

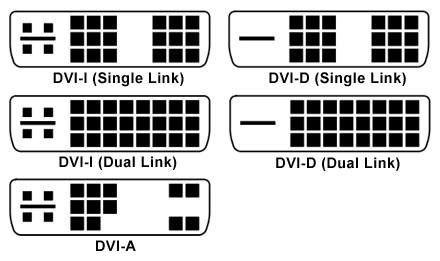

DVI.

DVI responde a las siglas de Digital Video Input. Apareció en 1999 y se utiliza para conectar monitores y proyectores a ordenadores. No transporta audio.

Tipos de conexiones DVI:

DVI-A: 17 pines, 12+5 y contiene las mismas señales que el conector VGA solo que con diferente disposición, por tanto la señal es analógica, con un simple adaptador se puede convertir a VGA.

DVI-D: Transmite únicamente señal de vídeo digital y puede ser tipo Single Link o de Dual Link. El segundo posee más ancho de banda. Con un simple adaptador se puede convertir a HDMI.

DVI-I: Transmite señal analógica y digital, con un simple adaptador se puede convertir a HDMI o a VGA.

DisplayPort.

Es un conector muy similar al HDMI en sus características técnicas, pero libre de licencias y cánones (no tiene la protección anti-copia HDCP como el HDMI), se suele incluir en algunas tarjetas gráficas y es raro verlo en televisores, su principal inconveniente es su incompatibilidad con DVI y HDMI. Hay dos tipos: el normal y el mini.

Soporta un flujo de datos máximo de 10,8 Gbit/s y resolución WQXGA (2560×1600) sobre un cable de 15 metros. En distancias más cortas soporta la resolución 4k.

4.- Glosario.

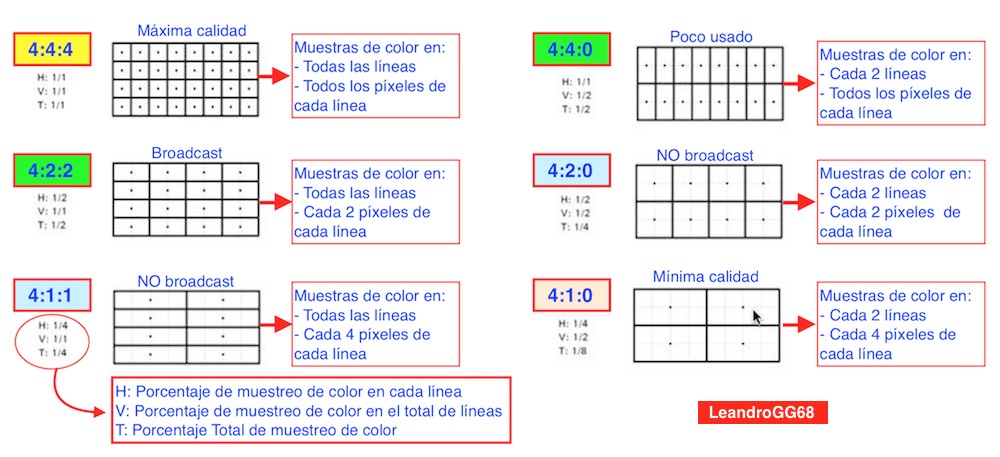

Subsampling: Determina el número de muestras tomadas de la señal de componentes. El primer número representa las muestras tomadas de Luminancia, que al ser un 4 indica que se muestran todos los píxeles.

Los dos números siguientes indican las muestras tomadas de las dos componentes de color R-Y y B-Y.

El códec utilizado determinará qué patrón de subsampling se utiliza, veamos algunos ejemplos:

4:4:4 : ProRes 4:4:4 XQ y 4:4:4 (apple).

4:2:2 : AVC-Intra 100 (panasonic), ProRes HQ, LT y Proxy (apple), Betacam Digital (sony), DVCPRO 50 (panasonic), DVCPRO HD (panasonic), Digital-S ( JVC), XDCAM HD (sony), Canon MXF HD.

4:1:1 : DVCPRO (panasonic), NTSC DV (panasonic), NTSC DVCAM (sony).

4:2:0 : Estándares MPEG-1, MPEG-2, MPEG-4 y códecs AVCHD (sony y panasonic), AVC-Intra 50 (panasonic), Apple Intermediate Codec, MJPEG, VC-1, PAL DV, PAL DVCAM (sony), HDV.

4:1:0 : Calidad muy baja similar al VHS, es poco utilizado.

Profundidad de color: Indica los bits utilizados para representar (cuantificar) cada pixel de una imagen. Puede ser de 8, 10, 12, 16 y 32 bits.

Con una profundidad de color de 8 bits se disponen de 256 niveles (28) para cuantificar cada pixel, como son tres componentes (rojo, verde y azul): 256 x 256 x 256 = 16.777.216 colores.

Si fuera de 10 bits se dispondrían de 1024 niveles (210) lo que nos daría 1.073.741.824, más de un billón de colores.

Por tanto si se va a corregir el color con programas como DaVinci Resolve es conveniente escoger un códec con profundidad de color de 10 ó 12 bits.

Bitrate: Es el Nº de bits por segundo que genera la trama de vídeo. El bitrate nos permitirá conocer lo que ocupa nuestro material en el disco duro y si los discos duros son capaces de grabarlo. Si trabajamos con varias capas en un programa de edición, debemos multiplicar el bitrate calculado por el nº de capas para saber si nuestro disco duro es lo suficientemente rápido para trabajar con este material. Como ejemplo un disco duro SATA de 7200 rpm suele grabar a unos 100 o 150 MB/s y un disco SSD desde unos 300 MB/s si es SATA hasta unos 2000 MB/s si es PCI express.

En este enlace se puede descargar una calculadora de bitrate para IOS y Android.

Los datos que introduciremos son: tiempo, códec, resolución, frame rate , nº de canales de audio, frecuencia de muestreo de audio y nº de bits de cuantificación de audio.

Esta calculadora nos proporciona la cantidad de memoria que ocupará el material en el disco duro en MB ó GB. Para saber el bitrate, debemos poner en TIME: 1 segundo y el resultado será en MB/s, multiplicando este valor por 8 lo podemos pasar Mbps (Mega bits por segundo).

En las emisiones de TDT, los operadores ajustan el bitrate en función del programa emitido, en la figura anterior se observa cómo afecta esto a una imagen estática.

Entrelazado: Es una técnica en la que se divide la información de una imagen (frame) en dos semimagenes (campos). Así es como capturan las imágenes las cámaras analógicas, las digitales además pueden capturar en Progresivo, en este caso la imagen se captura completa.

El entrelazado se realiza para ahorrar ancho de banda o bitrate y para evitar el parpadeo de la imagen pero genera problemas de imagen borrosa en objetos en movimiento.

Este sistema de exploración de la imagen se utiliza en la emisión de TV de calidad SD (standard) y en HD 1080i , «i» significa entrelazado y «p» progresivo. Cuando el programa de TV es de deportes lo habitual es que se emita en HD 720p. El bitrate de 1080i y 720p es similar.

En la figura anterior vemos un vídeo en pausa de un coche a 30 Km/h se observa lo siguiente:

- En progresivo los objetos en movimiento se ven de forma más nítida, ver detalle de rueda.

- Los objetos estáticos se ven igual en progresivo que en entrelazado.

- Con el procedimiento de desentrelazado mediante duplicación de líneas se mejora algo la visualización de los objetos en movimiento.

5.- Conclusión.

Recuerdo cuando, en mi colegio, instalamos el estudio de RTV (1999) para las prácticas del módulo de Grado Superior » Equipos de RTV «, Magnetoscopios DVCAM, controlador de edición, mesa de mezclas que aunque digital, las entradas/salidas eran analógicas, se grababa en cinta magnética. Entonces los equipos informáticos no tenían suficiente potencia para trabajar cómodamente la edición de vídeo, había que invertir mucho para eso.

La potencia de los equipos informáticos ha aumentado mucho en estos últimos años, lo que ha permitido trabajar fluidamente con resoluciones de vídeo mayores, actualmente estamos enclavados en la resolución 1080 (full HD) pero el 4K está empujando mucho, las TV que se están vendiendo actualmente a un precio asequible están preparadas para 4K.

Ya se está emitiendo en 4K en algunos canales de satélite y la llegada del DVB-T2, el sucesor de la TDT actual (DVB-T), traerá las emisiones en 4K de algunos canales. Muchos móviles graban en 4K usando el códec H265 (unos 350 MB/min). Para que se implante el 8K todavía falta, aunque algún móvil ya lo lleva.

El mundo del vídeo digital es muy cambiante y posee muchos términos, en este artículo he pretendido poner un poco de orden en este tema usando un lenguaje sencillo, sobre todo para ayudar a los que se inician en esto, espero haberlo conseguido.

Un Saludo.

![]()